Essay

En etikk med deadline

Kunstig intelligens hverken hater eller elsker oss – den kan likevel true livet slik vi kjenner det. Tanker fra en reise i Silicon Valley.

En superintelligent maskin vil kunne designe enda bedre maskiner. Det vil utvilsomt føre til en «Intelligensrevolusjon». Slik vil den første superintelligente maskinen bli den siste oppfinnelse mennesket trenger å lage, forutsatt at den er føyelig nok til å fortelle oss hvordan vi kan holde den under kontroll.

Irving John Good, 1965

Jeg er på «AI Summit» i San Francisco, eller som det også kaller seg: «begivenhet nummer én i verden på kunstig intelligens ». Det er hektisk, og «wow»-faktoren er stor. 92 prosent av innlederne er menn, og de fleste er her for å selge tekno-løsninger med slagord: Transformasjonen skjer her! Reduser tid fra data til intelligens! Som å ha makten fra tusen analytikere! KI – nå for alle industrier! Opplys det ukjente! KI som gir makt! Og min favoritt: Kunstig Løsning!

Kunstig intelligens (KI) gjennomtrenger stadig nye aktiviteter: Det reklameres med at KI kan gjenkjenne ansikter bedre enn mennesker, drive aksjehandelen, skrive sportsreportasjer, gjøre medisinske diagnoser, komponere musikk, forutsi hvilke fanger som vil gjøre nye forbrytelser, kjøre bil uten sjåfør, oversette mellom språk, og bli stadig bedre til å samtale med meg.

Her jeg går mellom salgsbodene tenker jeg på gullrushet i California, da San Francisco i 1846 vokste fra 200 mennesker til en mellomstor by på seks år. Folk kom fra alle kontinenter, hastet ut i omlandet for å sikre seg et stykke land med gull. San Francisco med Silicon Valley i sør og Seattle i nord er verdenssenter for et nytt gull nå. Her har de fem største plattform-selskapene hovedkontor: Facebook, Apple, Amazon, Google/Alphabet, Microsoft. De fremadstormende som har karet til seg en ny plattform med gull er også her: Uber, Airbnb, Tesla, Netflix.

Alle her inne forteller om de siste gjennombruddene i KI. Men det er ikke stedet man drar for å høre foredrag om hvordan KI kan ta makten fra menneskene.

Den skjer derimot i Commonwealth Clubs fornemme sal utenfor konferansen. Max Tegmark har kommet fra Boston for å lansere sin nye bok, Life 3.0. Being human in the age of artificial intelligence. Tegmark er leder for «Future of Life Institute» som forsker på det de anser som de to største eksistensielle trusler i vår tid: Atombomben og kunstig superintelligens.

Det er nerven i science fiction siden Frankenstein: Maskinen vi laget kommer ut av kontroll og angriper mennesker: Matrix, Terminator. At vi tenker på det som science fiction, gjør at mange nekter å tenke på det som virkelighet.

At vi tenker på KI som science fiction, gjør at mange nekter å tenke på det som virkelighet.

De fleste vitenskapsmenn har unngått forskning på KSI. De ville være seriøse, ikke spekulere om noe langt der fremme – det overlot de til forfattere og filmmakere. Men i løpet av de siste fem årene har dette snudd. Over 24.000 teknologer og vitenskapsmenn som vanligvis holder kjeft og jobber i sine laboratorier skrev i 2015 under et opprop som advarer mot kunstig intelligens. Max Tegmark var en av initiativtagerne til oppropet. Og mest berømt ble kanskje uttalelsen fra fysikeren Stephen Hawking, som ledsaget det:

Å tro at kunstig intelligens bare er science fiction, kan bli den verste feiltagelsen i historien og kanskje den siste (…) De primitive formene for kunstig intelligens som vi allerede har, har vist seg å være nyttige. Men jeg tenker at en fullstendig utvikling av kunstig intelligens kan bety slutten på menneskeheten (…) Den vil ta sitt eget løp, og designe seg selv igjen og igjen stadig raskere. Mennesker som er begrenset av sen biologisk evolusjon kan ikke konkurrere, og vil bli byttet ut.

Er dette realistisk – altså at vi kommer til å lage KSI som overgår vår intelligens og tar kontroll over oss? Forskernes svar kan deles i tre. Den første gruppen tror ikke det vil skje, i hvert fall ikke i dette århundret. Tidligere sjefsteknolog i Baidu, Andrew Ng, sier at det er like interessant å diskutere som faren for overbefolkning på Mars. Andre gruppen tror det skjer og er ubekymret positive. Ray Kurzweil, sjefsteknolog i Google, sier at KSI kommer før 2030 og jobber intenst for å kunne lade opp sin hjerne på internett og leve uendelig. Max Tegmark representerer den tredje gruppen: De tror det vil skje, men er bekymret. Det er nok den raskest voksende gruppen – blant dem finnes de forskerne som diskuterer KSI seriøst gjennom bøker og artikler, og som leder noen små institutter som forsker på det. (Se bokser)

Ray Kurzweil jobber intenst for å kunne lade opp sin hjerne på internett og leve uendelig.

Dagens KI er smal og virker på begrensede områder. Den har vært til nytte for milliarder, men det følger med problemer som overvåkning, sårbarhet, cyberkriminalitet, arbeidsledighet, avhengighet hos brukere og monopolmakt – og vi kan anta at med KSI vil både godene og skadene bli større.

Men KSI representerer i tillegg en annen utfordring. Stephen Hawking beskriver forskjellen slik: «Mens den kortsiktige virkning av kunstig intelligens avhenger av hvem som kontrollerer det, så avhenger den langsiktige virkningen om vi i det hele tatt kan kontrollere den.» Problemet er allerede synlig i maskinlæring som preger de fleste fremskritt i KI nå. For eksempel: Jeg synes det er irriterende at ikke Facebook og Google vil forklare algoritmene som styrer mine klikk. Men det er et verre at Facebook og Google ikke forstår det selv. Algoritmer kan være så kompliserte at mennesker ikke begriper hvordan de har kommet frem til et svar – det såkalte «svart boks-problemet».

«Svart boks-problemet» har ført til pinlige resultater hvor Google anbefaler mer lavtlønnede jobber til kvinner enn menn, og Amazon lager systemer som leverer varer senere til svarte amerikaneres boområder. Slike problemer kan kanskje rettes etter hvert, men – som professor Nick Bostrom ved Oxford påpeker – når vi skaper KSI kan vi ikke ta sjansen på å feile slik vi gjør nå. Vi får bare én sjanse. Vi må utvikle en kontroll og en etikk på forhånd – en etikk med deadline. Så da blir spørsmålet: Når faller deadline?

Vi må utvikle en etikk på forhånd – en etikk med deadline.

I det overfylte lokalet redegjør Tegmark for flere undersøkelser, der KI-forskere spår tidspunkt for når KI vil overgå den menneskelige intelligens. Rundt halvparten tror det vil komme før 2050, om bare 30 år. Kan vi stole på eksperter? Har de ikke tatt feil før? Forskerne Stuart Armstrong og Kaj Sotala gikk gjennom forutsigelser fra 1950-tallet til 2012, og mange eksperter spådde også da at det ville «komme innen 30 år». I 15 av disse profetiene har året de tippet allerede passert. Blir dette som dommedagssekter som hele tiden justerer tiden for dommedag når den ikke kommer? Det er for lettvint å latterliggjøre dette, slå det meg her jeg sitter – dette som Tegmark kaller «verdens viktigste samtale». For mange smarte folk tror dette vil komme. Og om jeg rekker å dø før KSI, hva så med mine barnebarn? Vår oppgave nå blir å spørre: Hvordan skal vi tenke om dette i dag?

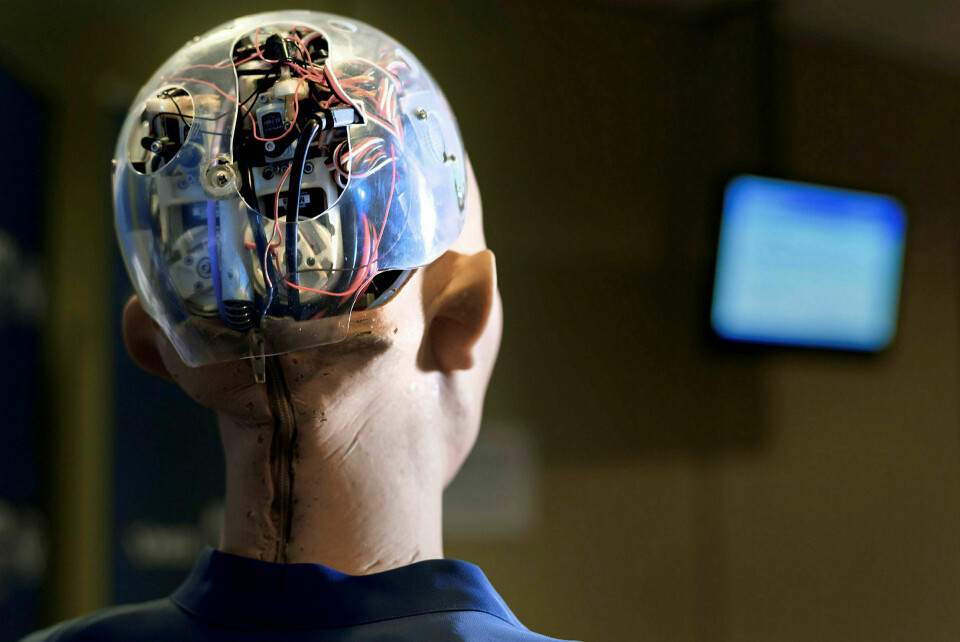

Max Tegmark forteller at vi lett utvikler tre feilforestillinger når vi tenker om KSI i dag. Første feil-forestilling er at KSI vil ligne på mennesker. Det finnes knapt en artikkel om dette uten et bilde av en menneskelignende robot, som Terminator eller sexy robotkvinner. Roboter i dag er dårligere til å orientere og bevege seg enn en toåring. KSI er ikke avhengig av en kropp, men kan bruke flere.«Det avgjørende er om den får adgang til internett», sier James Barrat i boken Our Final Invention. Slik kan intelligensen nå ut til milliarder av «internett av ting» og mennesker, og den kan spre seg i verdensrommet. Og den trenger ikke ligne vår intelligens, enn si våre følelser, så lenge den kan konkurrere oss ut.

Andre feil er å tenke at problemet er om KSI blir ond eller god. Eliezer Yudkowsky som arbeider på Machine Intelligence Research Institute, sier: «En KSI hverken hater deg eller elsker deg, men du er laget av atomer som kan bli brukt til noe annet.» Nick Bostrom har et sprøtt eksempel om en KSI som blir satt til å lage binders og ikke stopper før den har brukt opp halvparten av klodens materialer. Problemet er heller ikke bare om «onde mennesker» får kontroll over KSI. «Det meste av skaden gjøres av dem som vil føle seg viktige» sier Barrat.

En kunstig superintelligens hverken hater deg eller elsker deg

Tredje feil er å tro at KSI må være selvbevisst. Bevissthet er helt sentralt om vi skal forstå hva et menneske er, men i diskusjonen om KSI skaper det forvirring. Når du lager en definisjon av bevissthet, finnes det titalls andre. Det er antagelig nok at KSI har egne mål. Teknologi er målrettet – og representerer en slags nihilisme i sitt perfekte uttrykk for vilje til makt, men også i sin mangel på mening.

Felles for disse feilforestillingene er at mennesket tenker seg KSI i sitt bilde. Det tragiske resultatet kan bli at mennesket formes i KSI sitt bilde.

Det er ikke tilfeldig at jeg har havnet akkurat her i San Francisco. Ifølge James Barrat skal vi lete etter gjennombruddet for KSI på et sted med: 1) en enorm pengebinge, 2) innsamling av masser av data, 3) tilgang til mengder av energi og hardware, og 4) en samling av høytlønnede, velutdannede eksperter. Og i tillegg er det et premiss: At arbeidet holdes hemmelig for utenforstående.

Det er i USA det skjer. Europa har hengt litt med og Kina er på vei opp, men ingen er ennå på høyde med USA. Drivkreftene er de samme to som general og president Eisenhower advarte mot i sin berømte avskjedstale i 1961. Eisenhower var redd for «det militær-industrielle kompleks» i samarbeid med «den vitenskapelig-teknologiske eliten». Han mente de truet USAs demokrati.

At militæret er ledende bør ikke overraske noen. Militære i USA har finansiert det meste av forskningen på KI frem til nylig. De har ledet an i gjennombrudd som internett, GPS, språkoversettelse og talegjenkjennelse. I 2017 ble det bevilget rundt 120 milliarder kroner for KI-forskning over forsvarsbudsjettet i USA. Det er dobbelt så mye som alle midler til all forskning i Norge. De fleste store universiteter og viktige teknologiselskaper i USA samarbeider med militære. Militæret skummer forskningen, og via etterretningsorgan har de samlet enorme mengder data.

At militæret er ledende bør ikke overraske noen.

Det nye er opphopningen av penger, makt og data i Silicon Valley. Apple, Google og Microsoft satt ifølge en Moody-rapport i juli 2017 med rede kontanter på over 3800 milliarder kroner. Det tilsvarer tre norske statsbudsjett. Sammen med Amazon og Facebook er de verdens fem rikeste i markedsverdi. De utfordres nå av kinesiske selskap som Alibaba og Tencent – som snart har like mye penger, data og hardware.

Max Tegmark sier at DeepMind, som ble kjøpt av Google, er ledende på veien til KSI nå. Han kaller Larry Page, Googles grunnlegger for «den mest innflytelsesrike personen som noen gang har levd». Jeg tenker: Nå har han blitt fanget av et teknologisk tunnelsyn. Jeg ville foreslått Jesus, Muhammed, Konfucius eller Hitler, Djengis Khan. Så tenker jeg: vi får se om 1000 år.

«Vi skaper våre egne etterkommere», sa novellisten Samuel Butler i 1863; «og mennesket vil bli for maskinen, hva hesten og hunden er for mennesket». Forholdet mellom mennesker og dyr har lenge vært den mest brukte illustrasjonen på vår tilværelse om vi mister kontrollen til en overlegen intelligens. Da har vi tre muligheter: havne i zoologisk hage, bli husdyr eller kjæledyr eller bli utryddet – slik vi mennesker har utryddet halvparten av alle store dyr i løpet av de siste førti årene. Illustrasjonen er spekulativ, men kraftig – og bør provosere frem en diskusjon om vårt forhold til maskiner og dyr.

Hva gjøres med de moralske og samfunnsmessige hensynene; med etikken med deadline? Verdens største ingeniørorganisasjon IEEE konstaterte nylig at KI-arbeidet hadde ingen relevant etikk i utdanningen eller i industrien. Det var liten klarhet i ansvarsforhold, ingen oversikt over algoritmer, ingen uavhengig vurdering av bransjen.

Tegmark sier at han er blitt mer optimist i løpet av de siste tre årene, og henviser til oppropene og til «Asimolar-møtet» i Puerto Rico i januar 2017. Her møttes 147 personer – de fremste teknologer og investorer innen KI fra Europa og Nord-Amerika – og utformet «The Asimolar AI Principles». Verdiene de beskriver er velmente og vage, men representerer en ny vilje i en bransje som er allergisk mot reguleringer.

Det som har vekket mange er redselen for autonome drapsvåpen styrt av KI. Oppropet fra 2015 advarer mot et våpenkappløp. Autonome våpen kan bli en tredje revolusjon i krigføring, hvor den første var geværet og den andre var atombomben. I et nytt opprop i 2017 underskrevet av 116 teknologiselskaper fra 26 land, sier de: «Når kunstig intelligens er utviklet, vil det tillate en væpnet konflikt som vil bli kjempet i en skala større enn noensinne, og i en hastighet raskere enn mennesker kan begripe».

Autonome våpen kan bli en tredje revolusjon i krigføring

Max Tegmark understreker til slutt at dette er adskillig nærmere i tid enn fremtidsdrømmen om KSI. «Flere land arbeider for å lage fullautonome våpen. Det kan komme om år heller enn tiår», sier han og jeg forlater lokalet.

Dag Hareide er tidligere generalsekretær i Naturvernforbundet og rektor ved Nansenskolen – Norsk Humanistisk Akademi.